Robots.txt הוא קובץ טקסט שנמצא בשורש האתר ומספק הנחיות למנועי חיפוש לגבי אילו עמודים או חלקים באתר יש לסרוק או לא לסרוק. הקובץ משמש ככלי חשוב לניהול גישה של מנועי חיפוש לתוכן באתר, והוא יכול לשפר את יעילות הסריקה של מנועי החיפוש.

תפקידי קובץ Robots.txt:

- מניעת סריקות מיותרות: מאפשר לחסום גישה לדפים שלא נחוצים לאינדוקס, כמו דפי מנהלה, תוכן כפול או משאבי מערכת.

- שיפור יעילות הסריקה: עוזר למנועי החיפוש להתמקד בתוכן החשוב ביותר באתר.

- מניעת חשיפת מידע רגיש: מונע סריקה של קבצים או דפים שאינם מיועדים לציבור.

דוגמאות לשימושים נפוצים בקובץ Robots.txt:

- חסימת דפי מערכת כמו

/admin/. - חסימת גישה לתיקיות זמניות או קבצים ספציפיים.

- מתן גישה למפת האתר באמצעות שורת

Sitemap:.

שימוש נכון בקובץ Robots.txt דורש הבנה מעמיקה של מבנה האתר והאסטרטגיה השיווקית.

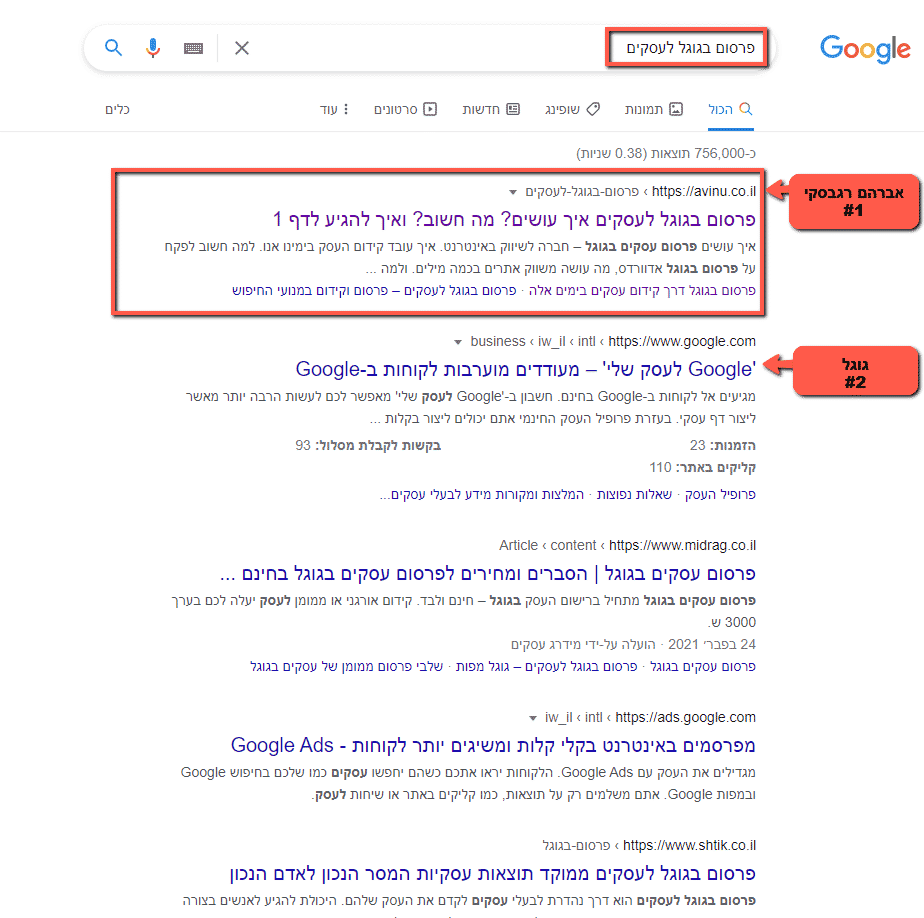

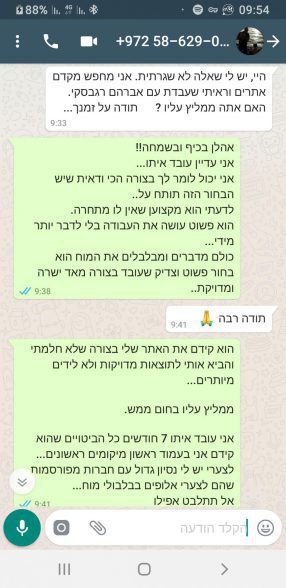

מומחה קידום אתרים בגוגל

יכול לנהל את הקובץ בצורה אפקטיבית כדי למנוע סריקות מיותרות ולשפר את נראות האתר במנועי החיפוש.